课程名称:计算机图形学(研究生)

报告主题:图形处理器(GPU)的历史、现状和展望

提交日期:2023 年 1 月 1 日

零、前言

首先,我的报告选择 GPU 发展历史该选题的原因是:在平时的学习研究中发现自己的硬件知识其实非常薄弱,几乎没有相关的硬件原理了解。虽然今后并不打算从事硬件相关的工作,但我认为“纸上得来终觉浅”——软件终究必须依靠当前的硬件工具进行运行,没有硬件知识终究会导致我的思路有很大的局限性,很多时候无法开发出效果更好、性能更高的系统、软件或者算法。因此我希望借此机会,通过查阅资料和自己的思考,使自己能对硬件知识、GPU 基础构架有一个广泛的了解。同时,GPU 的硬件设计制作发展和计算机图形学的发展也是相辅相成,无法分割的,因此本文也会带到一些图形学的发展历史,这样也算是在发展脉络上把两者结合了起来,我相信也能对自己有所帮助。

一、GPU 发展历史

(1) GPU 简介

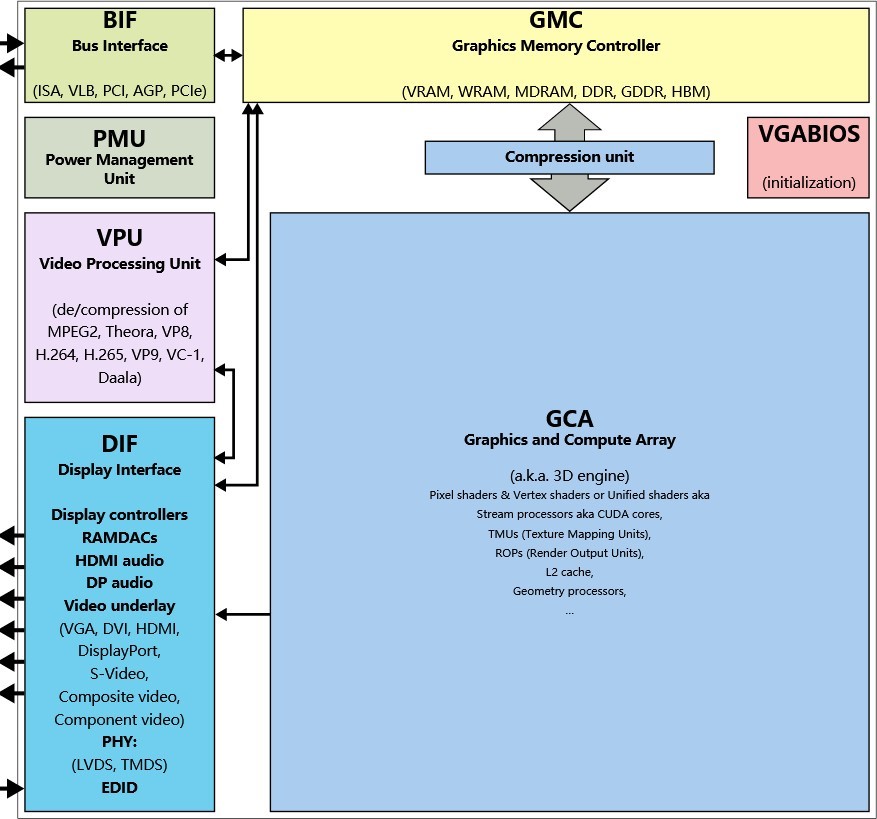

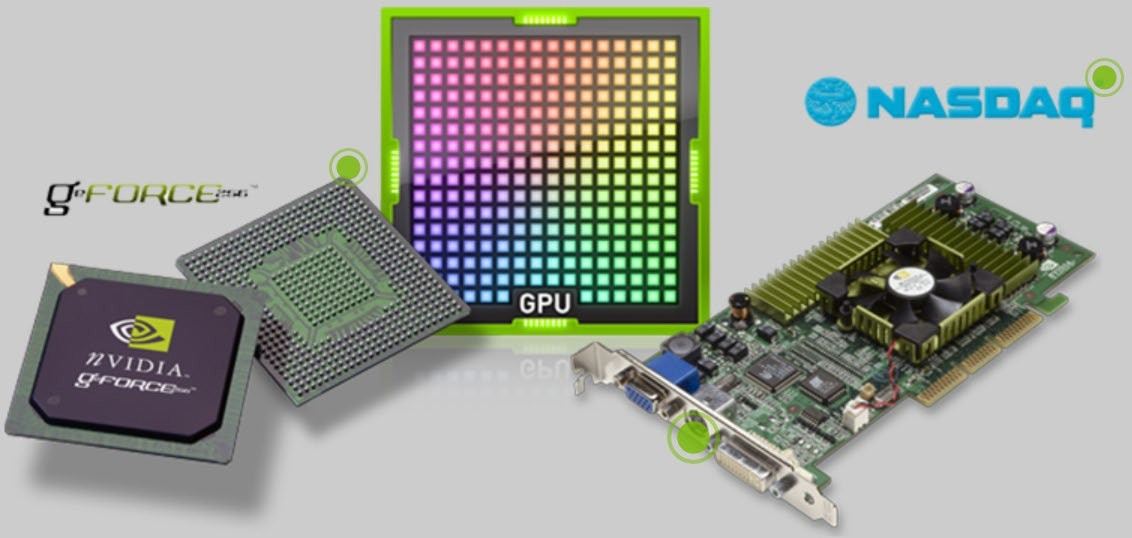

GPU 全称是 Graphics Processing Unit,中文名称是图形处理器。又被称为显示核心、显卡、视觉处理器、显示芯片或绘图芯片,是一种微处理器,专门用于在 PC、工作站、游戏机和一些移动设备(如平板电脑、智能手机等)上运行绘图运算工作。其最初发明时仅仅是为了处理图形计算工作,减轻 CPU 的负担,后来著名的科技公司 Nvidia 最早看到其在通用计算中的巨大潜力,推出了 CUDA 平台,使得 GPU 在具备强大的图形计算能力的同时,成为当前的人工智能、深度学习等热点研究领域不可或缺的硬件支持。

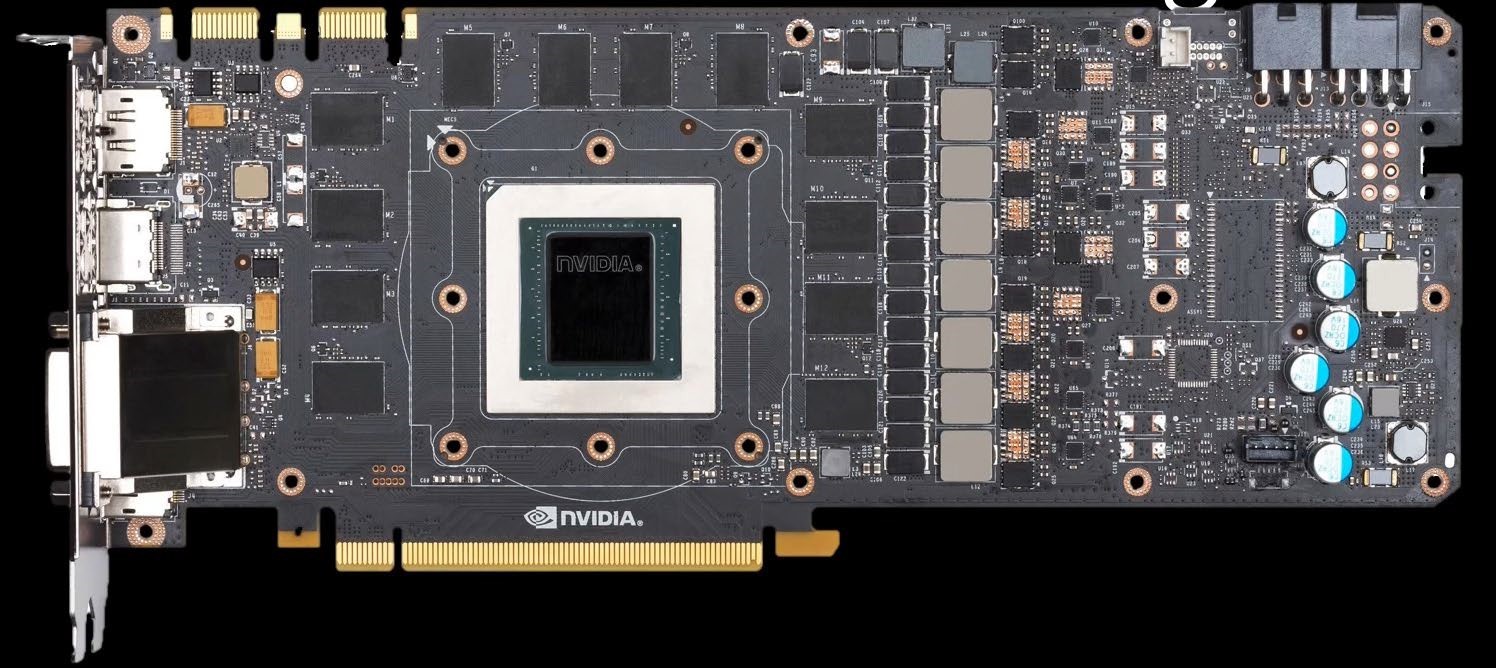

我们目前市面上比较常见的 Geforce GTX20、30、40 系列显卡,本质上都是以 GPU 为核

心的,其包括一块 GPU 核心芯片,一块 PCB 主板,以及其他集成在板上的显存、金手指、供电系统和散热等模块。如下图所示。

(2) 图形学的奠基

1962 年麻省理工学院(MIT)的博士 Ivan E. Sutherland 发表的论文《SKETPAD: A MAN- MACHINE GRAPHICAL COMMUNICATION SYSTEM》以及他的画板程序演示为计算机图形学奠定了根基,这篇论文中首次使用了计算机图形学“Computer Graphics”这个术语,其也因此被称为计算机图形学之父。下图是该论文的一些绘制结果。

此后近 20 年的时间里,计算机图形学不断有新的发展,完成了基础研究的部分。60 年代早期 MIT 的教授 Steven A. Coons 提出了通过插值四条任意的边界曲线来构造曲面,法国雷诺汽车公司的工程师 Pierre Bézier 也在 60 年代发明了 Bézier 曲线、曲面的理论。

上世纪 70 年代,区域填充、裁剪、消隐这些基础的图形学概念被先后提出,真实感图形学和实体造型技术也随之产生,不同的光照模型比如简单光照模型 Phong 模型也已经诞生。同时,图形学的标准制定也有标志性的进展, ACM 专门成立了图形标准化委员会,并先后于 1977、1979 年制定和修改了“核心图形系统”(Core Graphics System)。ISO 随后又发布了 CGI(Computer Graphis Interface,计算机图形接口)、CGM(Computer Graphics Metafile,计算机图形元文件标准)、GKS(Graphics Kernel system,计算机图形核心系统)、PHIGS(Programmer’s Hierarchical Interactive Graphics Standard,面向程序员的层次交互图形标准)等。

而在上世纪 80 年代,Whitted 提出了光线追踪算法,美国 Cornell 大学和日本广岛大学的学者引入了热辐射工程中的辐射度方法,标志着真实感图形的显示算法已逐渐成熟。

但是在图形学研究过程的最初 20 年中,计算机却没有配备专门的图形处理芯片,图形处理任务都是 CPU 来完成的。硬件的性能不足,在一定程度上也限制了图形学技术的实际落地。在 80 年代,专门的图形处理硬件终于开始逐渐出现和发展。

(3) GPU 与显卡的发展(产品脉络)

GPU 的发展史伴随着各种不同领域的科技公司的竞争和发展,比如半导体科技公司、硬件生产公司、软件开发公司、互联网公司等等,这些公司或许在发展的过程中都或多或少地参与过 GPU 的发展,因此下面将首先从各个不同的公司发布的产品来展示 GPU 的发展史。

(但是由于篇幅限制,本篇读书报告中将会省略一些没有那么标志性的产品。)

早期显卡概念及发展

1981 年,当时还没有显卡的概念,相应的名称叫做适配器或者寻址器。IBM 公司(国际商业机器股份有限公司)发布了首款黑白图形适配器(MDA),其物理外观如下图所示。其没有像素寻址的图形模式,而只具有单色的文本显示模式。只能显示 80 列 25 行的文本字符或者符号,用于绘制图表。

同年,IBM 发布彩色图形适配器(CGA)具有 16kb 视频内存,能在 8025 或 4025 分辨率下支持 16 种颜色输出,或者在 320200 分辨率下支持 4 种颜色输出。同时 IBM 发布的这两种图形适配器可以被安装在同一台电脑上,当时的操作系统 DOS 中包含的命令是用户可以在 CGA 和 MDA 之间切换显示。

1982 年,NEC(日本电气股份有限公司)发布了全球首款图形集成控制芯片 𝜇PD7220,该芯片可以绘制弧形、线条、圆形等图形基础元素,拥有高达 4Mbit 的图形内存,支持10241024 的分辨率和四种颜色输出,并且建立了易于使用的低级指令集,使得应用程序的开发者可以通过嵌入这些指令到程序里实现个性化的操作。

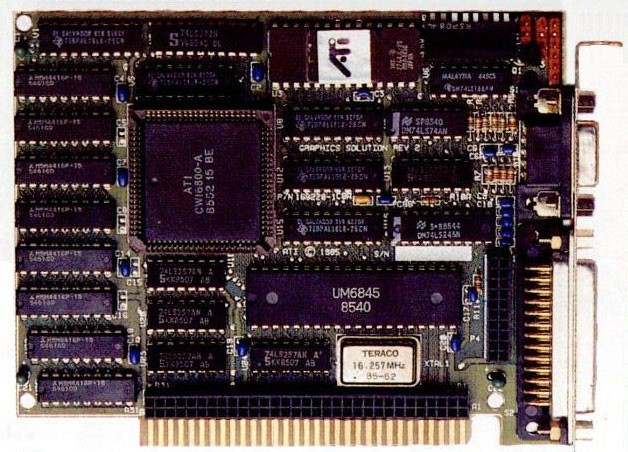

1985 年,著名的 ATI 公司成立,该公司也是当前市面上流行的 A 卡的初创者,同年该公司发布了第一款产品 ATI Graphics Solution Rev.1,如下图所示。1987 年 ATI 发布了ATI EGA Wonder 系列显卡,配备 256K 显存,采用 8 位 ISA 插槽。1990 年 ATI 推出升级款产品 ATI VGA Wonder+,采用全新的 28800-2/4/5 主芯片,该芯片当时采用的晶体管制造工艺为 800nm。1988 年,ATI 大力推广 ATI VGA Wonder 系列显卡,该系列显卡采用了后面一度被广泛使用的图形输出接口——VGA 接口,支持 1024*768 以上的分辨率,色彩支持达到 1600 多万色,就是我们常说的 24 位真彩色。

1990 年,Trident 9685 发布,能采用软件模拟来实现 DCI 和 DirectDraw 软 3D 加速,

标志着显卡步入 3D 时代,随后发布的 Trident 9750/9850 两款芯片则可以支持硬件 3D 加速。在 90 年代初期,功能比较均衡的 Trident 8900/9000 系列(16-bit ISA)为当时绝对的主流卡。

在 90 年代初期,1991 年 ATI 发布 ATI Graphics Ultra 系列显卡,此时微软的 Windows 操作系统已经炙手可热,因此该系列显卡也是面向 Windows 系统推出的。该显卡配备 2D 显示处理核心和 Mach8 协处理器,主要作用是分担 CPU 对图形处理的工作。1994 年 相继推出了 Mach 32 、Mach 64 和 Mach 64-VT,支持 32 位色彩和 VESA 标准,Mach64 更是加入了视频加速、 YUV/RGB 颜色转换和硬件缩放等功能,使得电脑 AVI 和 MPEG 视频不再需要 CPU 加速。但以上这些 GPU 主要还是面对 2D 图形处理的。

在 80 年代到 90 年代初期的这段时间里,GPU 的研发和设计基本处于一个群雄逐鹿的态势。除了上面提到的之外,还有很多公司参与过 GPU 的发展,比如 SGI(Silicon Graphics, 美国硅图公司)推出的高端图形工作站、苹果推出的具有图形化操作界面的个人电脑、TI(德州仪器,一家全球化半导体设计与制造企业)推出的 CPU 和 GPU 结合的完整 32 位处理器, Inter 的图形协处理器等。

VooDoo 开启的个人电脑时代的显卡发展

但前期的很多显卡设备并没有在个人电脑上得到很好的推广,直到 1994 年 3Dfx 公司创立,并于 1995 年推出了他们的第一款显卡 3Dfx VooDoo(国内音译为巫毒),这是第一款真正意义上的消费级 3D 显卡,他将个人电脑真正意义上地带入了 3D 世界,也是一个极具标志性的时间节点。

1993 年,黄仁勋联合自己的技术伙伴一起成立了后来的显卡巨头 Nvidia。1995 年, Nvidia 推出了首款以 NV1 图形芯片为核心的多媒体解决方案。但是他们试图抛弃三角形绘制改用四边形绘制,并不兼容当时主流的图形绘制库 OpenGL 和 Direct3D(直到现在仍然是主流的图形绘制解决方案)。这使得他们的方案不被市场所接纳,几乎无人问津。

但 Nvidia 很快做出了调整,1997 年,Nvidia RIVA 128 诞生,从此 Nvidia 放弃了自己的 API 接口,转而支持微软的 Direct3D 技术。RIVA 128 拥有 128 位内存总线,像素填充速率达到 100Mpixel/s,并且性能已经强于 VooDoo。

而在几乎同期的 1996 年,ATI 推出了他们第一款 3D 图形处理器 ATI 3D Rage 系列, 该卡性能一般且兼容性较差,但紧接着推出的 3D Rage Ⅱ 就解决了兼容性问题,并提供了两倍的 3D 性能。

之后,3Dfx 于 1998 年推出 VooDoo2,增加了一个纹理处理单元,允许一次处理两个纹理,并推出了著名的 SLI 技术(Scalable Link Interface),可以并联两块 VooDoo2 使用,但其本质上是 3D 子卡,需要配合 2D 卡使用。该技术在之后 3Dfx 被 Nvidia 收购后仍被迭代使用过。

1999 年 3Dfx 推出了第一款真正全新设计的 2D+3D 显卡 VooDoo3,但由于其不支持当时流行的卡槽 AGP 2X 的绝大多数特性,仅仅拥有 16bit 显存带宽和 16MB 显存容量,加之 3Dfx 收购 STB System 后不再授权芯片给第三方厂家生产,很多厂商转而与 Nvidia 合作。

1999 年年底,Nvidia 显卡核心代号从 NV5 飞升到 NV10,正式推出 Geforce 256 显卡, 他是首款完全支持 DirectX 3.0 的显卡,也第一次支持使用 T&L 光影转换引擎进行复杂的坐标处理和光源映像的运算。伴随着该显卡的推出,Nvidia 首次提出了 GPU 的概念。

同年,ATI 推出 Rage 128 和 Rage 128 Pro 显卡,并开启“曙光女神”计划推出 ATI

Rage Fury MAXX,将两颗 Rage 128 Pro 的核心集成在一张 PCB 上面,使用类似 SLI 的技术, 实现显卡性能翻倍,但其性能仍然没有超过 Nvidia。

2000 年,3Dfx 公司在多次跳票后先后推出采用单 VSA-100 芯片方案的中低端第四代显卡 VooDoo4 4500 和采用两块 VSA-100 芯片的 VooDoo5 5500,但旗下的 STB 工厂产能低下, 不能满足市场需要,最终 3Dfx 被 Nvidia 收购。自此,Nvidia 和 ATI 两分天下的局势基本形成。

Nvidia 和 AMD 两分天下的 GPU 发展(由于更新迭代速度较快,因此本部分尽量选取重要的节点,并不会囊括所有产品)

2001 年,Nvidia 发布 Geforce 3 系列显卡,核心包含 5700 万个晶体管,支持 Direct8.0 和可编程的 Pixel Shaders;AVI 发布基于 RV200 核心的 Radeon 7500,RV200 本质上是 RV100的频率提高版本。

2002 年,Nvidia 发布 Geforce 4 系列,完整支持 Direct8.0,引入 NfiniteFX 引擎, 且配备了两个顶点着色引擎;ATI 推出基于 R300 核心的 Radeon 9000 系列,首次引入 VPU 视觉处理器技术,率先支持 Direct9.0,并且基于先进的 150nm 制程技术,晶体管数据多达1.1 亿个。

2004 年,Nvidia 于 4 月发布全新采用 NV40 系列核心的 Geforce 6800 系列显卡,其中Geforce 6800 Ultra 具有 16 条渲染管线,全面支持 Direct9.0c,且加入大量新技术,比如 Pure Video 和从收购的 3Dfx 公司演变而来的 SLI 多卡互联技术。

2006 年,Nvidia 8000 系列发布,使用 G80 核心,65nm 工艺制程,内部集成了大量流处理器,具有更大的显存带宽和更高的频率,是首批支持 DX10.0 的产品,且从 G80 核心开始 SLI 技术支持 3 显卡互联,如下图;ATI 推出核心代号 R500 的 Radeon X1000 系列,支持Direct9.0c、HDR、CrossFire 双卡互联,且完美兼容 SM3.0 技术,同年 ATI 被 AMD 收购, 但人们对 A 卡的称呼仍然没有变。

2008 年,Nvidia 发布了采用第二代统一渲染架构的显卡 GTX260 和 GTX280,其 GPU 核心代号为 Tesla,也正是在这时 Nvidia 意识到 GPU 不应该局限于图形计算,而应该走向通用计算,因此 Nvidia 同时推出了 Cuda 计算平台和 PhysX 物理引擎等技术。

2010 年,AMD 发布 Radeon 6000 系列显卡;Nvidia 发布 Geforce300 和 Gefore400 系列,核心研发代号为 Fermi,其中 GTX480 拥有 30 亿个晶体管,480 个 Cuda 核心,显存首次使用GDDR5,支持 DX11 且加入 PolyMorph 引擎技术,拥有强大的曲面细分能力。

2012,Nvidia 的 Geforce600 系列,核心研发代号为 Kepler,增加了 Cuda 核心数,并升级至第二代 PolyMorph 引擎以及纹理单元等;同年,AMD 彻底改良 GPU 核心架构,推出了著名的 GCN 架构,最早采用 28nm 制程技术。囊括了全新的 AMD Enduro(显卡切换技术),AMD ZeroCore 电源技术以及 DDM Audio 独立数字多点音频等技术。

2016 年,Nividia 推出使用全新 Pascal 架构的新显卡 Geforce Rtx 10 系列,同时使用台积电 16nm 和三星的 14nm 制程技术;而 AMD 推出基于第四代 GCN 架构 Polaris 北极星的显卡 Radeon RX400 系列

2018 年,Nvidia 推出 RTX 20 系显卡,首次使用 Turing GPU 的实时光线追踪技术。

2020 年,AMD 推出基于第二代 RDNA 架构的 RX6000 系列,支持光线追踪。而 Nividia 发布基于全新 Ampre 安培架构的 RTX30 显卡。

2022 年,AMD 发布了 RX7000 系列,Nvidia 则发布了 RTX40 系列。

(4) GPU 与显卡的发展(核心技术脉络)

GPU 的发展,离不开核心技术的支持,可以说,等不到背后技术的发展,仅依靠一方的力量无法开创现在 GPU 的发展程度,我们必须关注核心技术的发展,才能在当前中国技术发展被卡脖子的时候,更好地找到突破的方向。

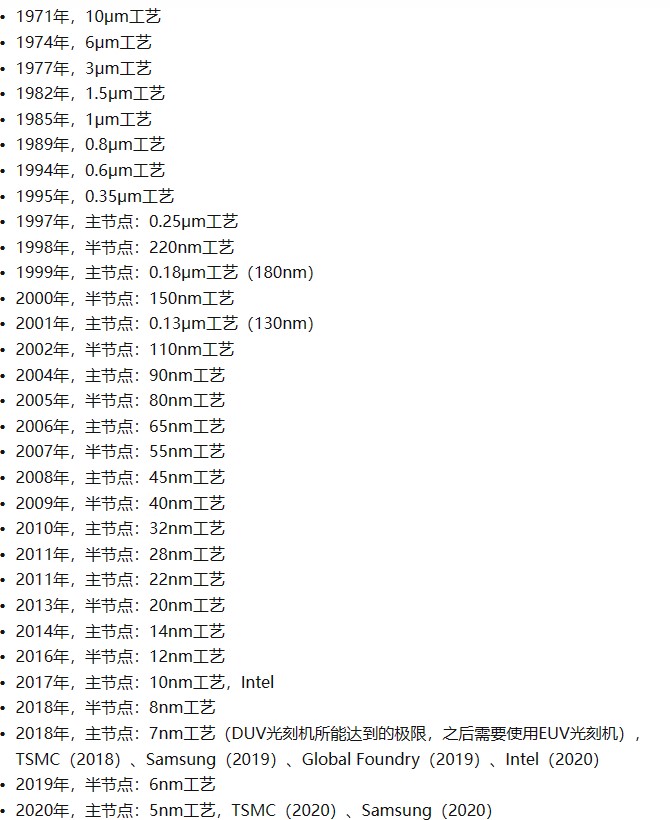

晶体管制作工艺发展

GPU 芯片的核心元件是半导体。当今的半导体领域,不同的芯片中只有 GPU 芯片可以以三倍于摩尔定律的速度快速迭代发展。(摩尔定律是英特尔创始人之一戈登·摩尔根据自己的经验总结的半导体发展规律,其核心内容为:集成电路上可以容纳的晶体管数目在每经过大概 18-24 个月便会增加一倍。也就是说,芯片处理器的性能大约每两年能翻一倍。)

集成电路从产生到成熟大致经历了这样几个过程:电子管——晶体管——集成电路—— 超大规模集成电路。由于集成电路的发展历史过于庞大,因此这里只对近年来的集成电路和晶体管制作技术作介绍。芯片是由晶体管作为最小单元组成的,一块有限大小的芯片上能集成多少晶体管,一定程度上就决定了芯片的性能。而想集成更多晶体管,就需要更先进的技术将晶体管做的更小,我们平时说的 22nm 制程也就是一个晶体管的大小。

以下是近年来制程技术的历史发展情况:

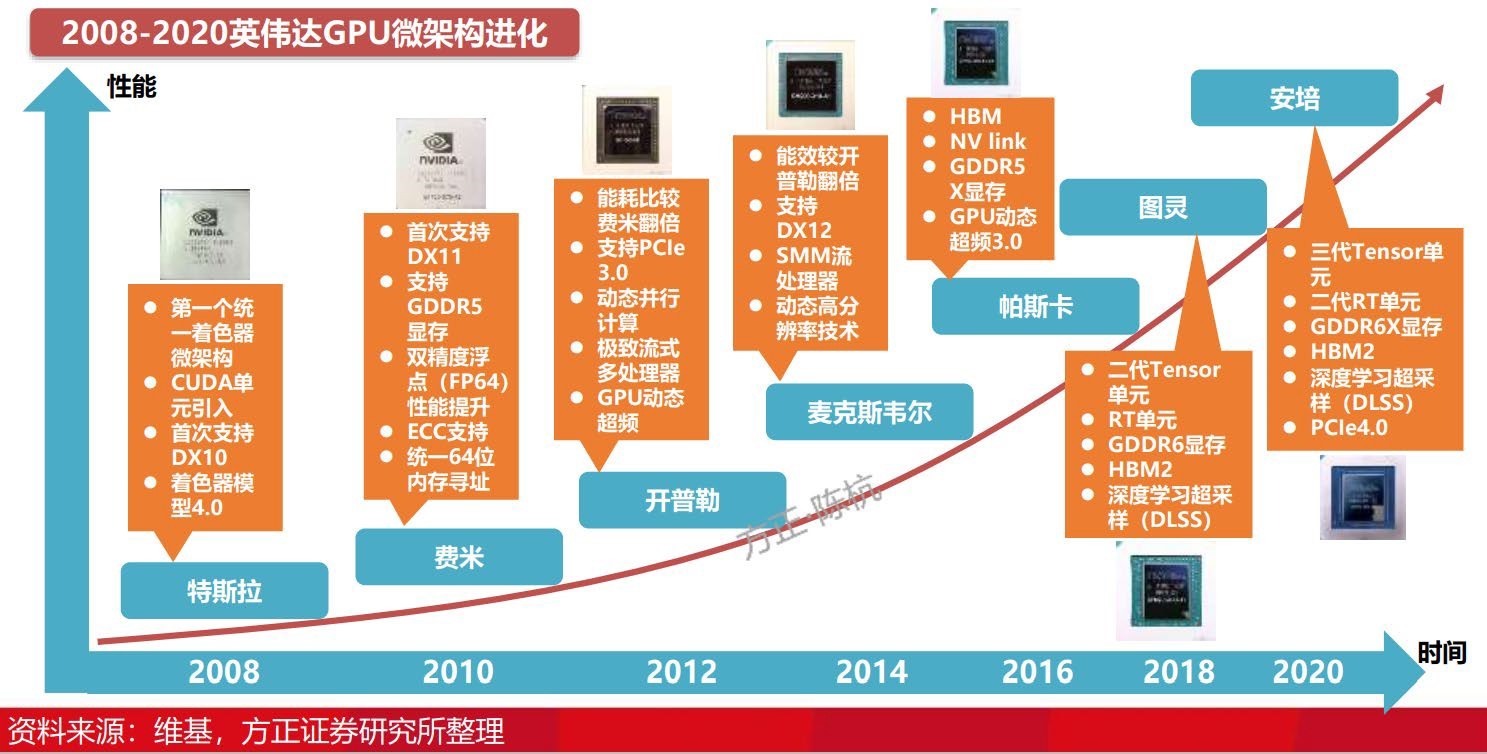

GPU 核心架构发展

晶体管制作工艺限制了芯片计算强度的上线,但芯片的电路设计同样至关重要,决定着能否将芯片上的晶体管利用率最大化。在 GPU 几十年的发展史中,每一次核心架构的变迁都意味着一次较大的技术更迭和跨越。从 2008 年开始,Nvidia 的 GPU 架构几乎保持了每 2 年一次大更新,带来更多更新的运算单元和更好的 API 适配性,也使得 GPU 的性能不断攀升。AMD 也在近些年不止一次进行过核心架构的整体换血更新。在核心架构每次的大换代之间, 也会针对性地进行一些小升级,比如采用 Kepler 二代微架构的 GK110 核心相较于采用初代Kepler 微架构的 GK104 核心,升级了显卡智能动态超频技术,提升了 CUDA 运算能力,极致流式多处理器(SMX)的浮点运算单元提升 8 倍,加入了 Hyper-Q 技术,提高 GPU 的利用率, 更新了网格管理单元(Grid Management Unit),为动态并行技术提供了灵活性。下图展示了近年来 Nvidia 的 GPU 核心架构的变迁(图源网络):

接口类型变迁

接口类型是指显卡连接主板所采用的接口种类。接口的决定了 GPU 和 CPU 数据传输的最大带宽。PCI 是 Peripheral Component Interconnect(外设部件互连标准)的缩写,几乎所有的主板产品上都带有这种插槽,它是个人电脑中使用最为广泛的接口。PCI 插槽也是主板数量最多的插槽类型,在流行的台式机主板上,ATX 结构的主板一般带有 5~6 个 PCI 插槽,M-ATX 主板也都带有 2~3 个 PCI 插槽,可见其应用的广泛性。

显卡发展过程中,出现过 ISA、PCI、AGP(发展过程包括 AGP1X、AGP2X、AGP4X、AGP Pro、AGP8X)等几种接口,所能提供的数据带宽依次增加。2004 年,PCI Express 接口标准被正式提出,目前的显卡大多使用 PCI-e 接口。

显存技术发展

计算机运行中需要内存,而图形计算单元同样需要显存。目前比较常看到的 DDR、GDDR、HBM 都是动态随机存储器,即都是内存。DDR 和 GDDR 是我们日常计算机中使用的内存,相对加工工艺成熟,技术标准体系健全,其中 GDDR 是面向显卡和 GPU 的显存。DDR 是 Double Data Rate 的缩写,指的是在一个时钟周期内传输两次数据的双倍速率同步动态随机存储器。GDDR 是用在显卡上的内存,目前也已经发展到了第五代。相对于 GDDR3、GDDR4 而言,GDDR5 显存拥有诸多技术优势,拥有更高的带宽、更低的功耗、更高的性能。

而 HBM 是同样是用在显卡中的内存(显存),和 GDDR 区别是采用垂直堆叠半导体工艺生

产的的存储芯片,通过被称为“硅透”(TSV)的线相互连接,实现低功耗、超宽带通信通道, 相比 GDDR5 减少了通信成本,单位带宽能耗更低,制作工艺更高,所以极大减少晶元空间。但加工成本更高。

DirectX 及 Shader Model 发展

上文中曾经提到的 SM3.0 是 Shader Model 3.0 的缩写,该技术随 DirectX 更新。更好的 Shader Model 支持在很大程度上丰富了游戏研发时的编程模型。

SM3.0 中 3.0 像素渲染引擎 3.0 和顶点渲染引擎 3.0 的最大指令数分别从上一代的 256

个和 96 个提升到 65535 个。

SM4.0 放弃之前版本中分离的像素渲染引擎以及顶点渲染引擎架构,而是通过统一渲染架构实现像素或者顶点渲染的功能,大幅度地提高 GPU 的资源利用率。加入了新的几何渲染引擎,首次允许 GPU 动态创建或者删除图等。

SM5.0 在指令集方面进行了扩充和改进,DirectX 11 采用了针对 HDR 的 BC6H 压缩算法和针对 RGB 的 BC7 压缩算法。并且支持多线程处理技术,通过引入延迟执行这一指令,将一个渲染进程拆分成多个线程,实现了多线程处理一个渲染进程的效果。

二、GPU 发展现状

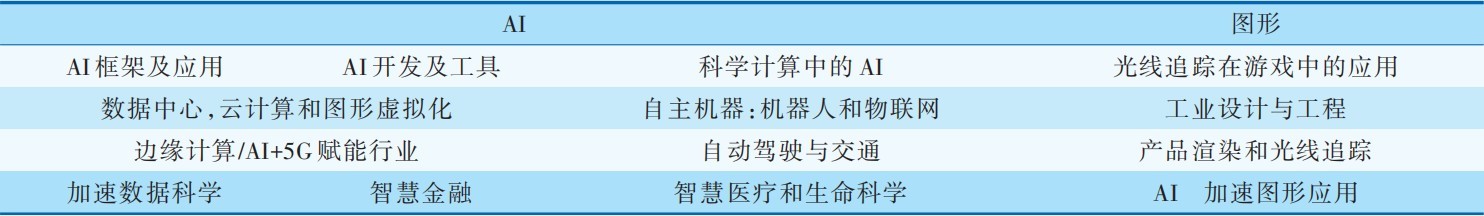

Nvidia 在 2019 年举办的中国 GTC 大会上,设置了两大主题,具体主题如下图所示。可以预见,在未来的发展方向上,以 AI 深度学习等为代表的 GPU 通用计算将会大大增加其权重, GPU 的未来趋势无外乎 3 个:大规模扩展计算能力的高性能计算(GPGPU)、人工智能计算(AIGPU)、更加逼真的图形展现(光线追踪 Ray Tracing GPU)。

在高性能计算方面,NVIDIA 于 最 新 发 布 的 NVIDIA A100 显卡可针对 AI、数据分析和 HPC 应用场景,在不同规模下实现出色的加速,有效助力更高性能的弹性数据中心。A100 的芯片是使用 NVIDIA Ampere 架构的 Tensor 核心。Tensor 核心借助 Tensor 浮点运算 (TF32) 精度,能在不更改代码的前提下,提供比之前的 Volta 核心 高 20 倍之多的性能;若使用自动混合精度和 FP16,性能可进一步提升 2 倍。与 NVIDIA® NVLink®、NVIDIA NVSwitch™、PCIe 4.0、NVIDIA® InfiniBand® 和 NVIDIA Magnum IO™ SDK 结合使用时,它能扩展到数千个 A100 GPU。A100 提供 40GB 和 80GB 显存两种版本,其中的 80GB 版本由于 GPU 显存增加,且提供超快速的显存带宽(每秒超过 2 万亿字节 [TB/s]),拥有处理超大型模型和数据集的能力。

在光线追踪和图形显示方面,Nvidia 最新发布的RTX4090 作为一款性能出众的 GeForce GPU,在性能、效率和 AI 驱动的图形领域实现了质的飞跃。这款 GPU 采用 NVIDIA Ada Lovelace 架构,配备 24 GB 的 G6X 显存,可为游戏玩家和创作者带来出众的体验。

RTX 30 使用的三星 8nm 工艺本质是 10nm,而 RTX 4090 则是采用的台积电定制 4nm 工

艺,至少进步了 2 代半。RTX 4090 拥有 763 亿晶体管,就说每 mm2 有 1.25 亿晶体管,相比

0.45 亿的 RTX 3090 Ti 密度提升了 178%,核心频率也从 1860 上升到 2520MHz,提升幅度高达 35%。

(1) 芯片制程技术发展现状

2022 年 6 月 30 日,三星电子宣布:3 纳米芯片量产!根据三星官网的数据,3nm 芯片相比之前的 5nm 芯片,性能提升 23%,功耗降低 45%,芯片面积缩小 16%。

2022 年 7 月 1 日,长电科技宣布实现 4nm 手机芯片封装,以及 CPU,GPU 和射频芯片的集成封装。

中国芯片现状:

全产业链国产化可实现 90nm(中国目前最顶级的、完全自主知识产权的量产化光刻机: 上微电(SMEE)的 SSA600/20 型 90nm 光刻机);

全产业链去美化可实现 28nm(中芯国际稳定制程 28nm,使用 ASML 的 DUV 光刻机); 全产业链最先进的制程是 14nm(中芯国际目前最先进的制程是 14nm,2019 年 14nm 制

程工艺量产,代工华为的麒麟 710A 芯片)。

(2) 国内 GPU 产品线发展现状

近些年国产 GPU 蓬勃发展,由于在芯片技术上被卡脖子,国内必须加紧 GPU 芯片的研发和设计发展。其中,发展比较快的有以下几个公司:

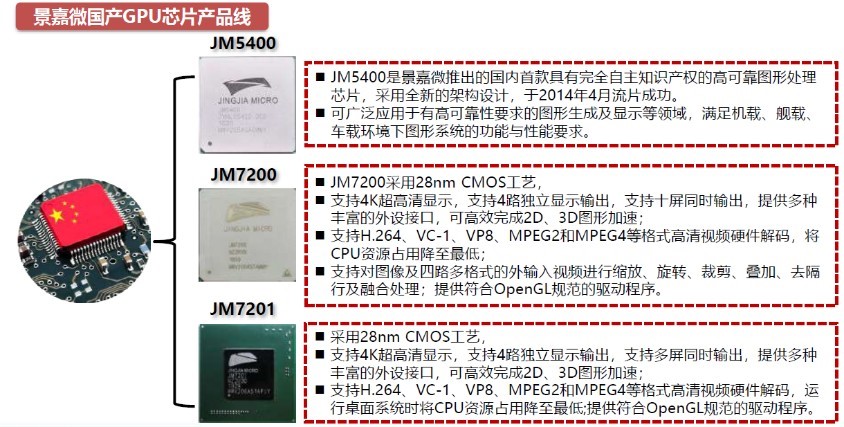

景嘉微

成立于 2006 年 4 月的长沙景嘉微公司是目前唯一专注于国产GPU 芯片设计的上市公司。2014 年 4 月,景嘉微成功研发出国内首款具有完全自主知识产权的高可靠、低功耗 GPU 芯片-JM5400,打破了中国 GPU 市场长期被国外产品垄断的局面。

景嘉微 GPU 已完成与龙芯、飞腾、麒麟软件、统信软件、道、天脉等国内主要 CPU 和操作系统厂商的适配工作;与中国长城、超越电子等十余家国内主要计算机整机厂商建立合作关系并进行严格的产品测试;与麒麟、长城、苍穹、宝德、超图、昆仑、中科方德、中科可控、宁美等多家软硬件厂商进行互相认证,共同构建国产化本土化的计算机应用生态。

芯动科技

2020 年 10 月,位于武汉的芯动科技宣布与 Imagination 达成合作,将采用多晶粒

(chiplet)和 GDDR6 高速显存等 SoC 创新技术,基于 Imagination 全新顶配 BXT 多核架构,开发“风华”系列 GPU。

在信创和算力安全方面,“风华”系列 GPU 内置物理不可克隆 iUnique Security PUF 信息安全加密技术,提升数据安全和算力抗攻击性,支持桌面电脑和数据中心 GPU 计算自主可控生态。这款 GPU 芯片自带浮点和智能 3D 图形处理功能,全定制多级流水计算内核,兼具高性能渲染和智能 AI 算力,还可级联组合多颗芯片合并处理能力,灵活性大大增加,适配国产桌面市场 1080P/4K/8K 高品质显示,支持 VR/AR/AI,多路服务器云桌面、云游戏、云办公等应用场景。

三、我的感想

通过这几天的查找资料和学习,我对芯片制造、晶体管、GPU 核心架构等都有了一个普遍的了解。我觉得这次学习对我的提升是非常明显的,有很多之前完全不了解的硬件知识可以进行一个系统的认知。

在学习的过程中,我也有很多感想。

首先就是在查阅一些图形学和 GPU 发展的历史的时候,我惊奇地发现,其实 GPU 技术几乎从上世纪 80 年代才开始发展,最核心最快速的发展进程也就集中在上世纪末和本世纪的

20 年内,这让我有一种很特别的感受,似乎就是在我作为一个个体成长起来的同时,图形学和 GPU 软件和硬件发展领域不断有新的技术涌现出来,行业飞速前进,而当我成长到决定之后从事图形学相关研究方向时,发现已经有很多研究成果,这些成果让现在的我们得以站在巨人的肩膀上,享受到更强大的计算机性能,极大地方便了研究的过程。

第二,在查阅资料的过程中,我了解到,GPU 的研发是一个非常复杂的过程,涉及到很多方面的技术。当前芯片制造工艺被卡脖子,最严重,也最难突破的关键点是制作精密芯片的光刻机,我们国家没有成熟的光刻机技术,就没办法制作芯片。而目前光刻机只有荷兰的ASML 公司可以生产,一旦该公司不出口给我国光刻机,我们就完全无法自主制作芯片。因此我们国家要想突破这层桎梏,就必须去探索发展光刻机技术。

第三,在学习历史的过程中,我也从各公司的发展中学习到一些失败的经验,比如Nvidia 在刚创始时就妄图改变行业规则,而导致了失败,GPU 终究是硬件工具,硬件的制作需要软件来驱动,实现更多功能,我们可以看到历代 GPU 的发展都伴随着能支持 DX 系统的迭代,因此如果不能和目前主流的 Windows、DirectX、OpenGL 相兼容,就不会受到市场的欢迎,自然也就无法在商业上推广。

第四,GPU 的发展本质上也需要核心架构的发展,正如之前提到的,没有好的核心电路架构,就算晶体管制程工艺发展好了,也无法释放其计算能力,因此,大力发展我国的微电子电路设计能力是十分有必要的,好的核心架构和技术甚至能获得一定的专利保障。

第五,GPU 发展离不开技术的支持,不同厂商的 GPU 都有其核心的竞争技术,比如 Nvidia的 DLSS,AMD 的 FSR 和 Inter 的 XESS。作为一款产品,不拿出新的技术支持,GPU 也终究只是一些复杂精细的元件,Nvidia 目前是一家独大的显卡公司,但与此同时,他也引领着图形学尤其是渲染领域很多核心技术的发展,在我之前写毕业论文的时候就曾经感受过这一点,Nvidia 强大的技术能力也体现在他们有很多工业界的方法去得到更好的图形效果,比如基于方差估计的 MipMap Roughness 优化等。

第六,我国目前的 GPU 事业也已经有了一定发展,我们不能妄自菲薄,但是也不能好高骛远,必须承认的是,我们目前独立制造的 GPU 仍与世界先进技术存在着至少两三代的代差,比如国内一些显卡厂商的 GPU 算力只能对标 Nvidia 的 10 系显卡,我国 GPU 发展事业仍然道阻且长。

参考文献

[1] Ivan E. Sutherland(Massachusetts Institute of Technology). SKETPAD: A MAN- MACHINE GRAPHICAL COMMUNICATION SYSTEM[J]. PROCEEDINGS—SPRING JOINT COMPUTER CONFERENCE, 1963.

[2] NVIDIA. NVIDIA launches the World’s first graphics processing unit: GeForce 256[EB/OL]. (2002-01-11) [2023-01-06].

[3] BRIDGES R A, IMAM N, MINTZ T M, et al. Understanding GPU power: a survey of profiling, modeling, and simulation methods[J]. ACM Computing Surveys, 2016, 49(3): 41:1-41:27.

[4] Jacob Gaboury, Alvy Ray Smith, Mary Whitton,etc. 2021. Making Computer Graphics History Public: SIGGRAPH 2021 Retrospective Panel. In Special Interest Group on Computer Graphics and Interactive Techniques Conference (SIGGRAPH ‘21 Panels). Association for Computing Machinery, New York, NY, USA, Article 8, 1- 3.

[5] Prashanta Kumar Das, Ganesh Chandra Deka. History and Evolution of GPU Architecture[M].

[6] NVIDIA. NVIDIA HISTORY-A Timeline of Innovation[EB/OL]. [2023-01-06]. https://www.nvidia.com/en-us/about-nvidia/corporate-timeline/

[7] MACRI J. AMD’s next generation GPU and high bandwidth memory architecture: FURY[C]// Hot Chips Symposium. IEEE, 2015: 1-26.

[8] BENAMOU J. Big ray tracing[J]. Journal of Computational Physics, 1996, 128(2): 463-474.

[9] 熊 庭刚 .GPU 的发 展历 程、未 来趋 势及 研制实 践 [J]. 微纳 电子 与智能 制造,2020,2(02):36-40.

[10] Graham Singer. The History of the Modern Graphics Processor-The Early Days of 3D Consumer Graphics[EB/OL]. (2022-12-01) [2023-01-06]. https://www.techspot.com/article/650-history-of-the-gpu/

[11] Olena. A brief history of GPU[EB/OL]. (2018-02-22) [2023-01-06]. https://medium.com/altumea/a-brief-history-of-gpu-47d98d6a0f8a

[12] JAKE FRANKENFIELD. What Is a Graphics Processing Unit (GPU)? Definition and Examples[EB/OL]. (2021-09-07) [2023-01-06]. https://www.investopedia.com/terms/g/graphics-processing-unit-gpu.asp

[13] 丽台科技. GPU 硬件的发展史是怎样的?[EB/OL]. (2016-02-13) [2023-01-06]. https://www.zhihu.com/question/21980949

[14] biaoJM. GPU-directX 的发展历史[EB/OL]. (2018-04-28) [2023-01-06]. https://www.cnblogs.com/biaoJM/p/10186721.html

[15] 顾正书. 国产 GPU 风生水起,英伟达和 AMD 感受到威胁了吗?[EB/OL]. (2021-03-31) [2023-01-06].

https://www.eet-china.com/news/202103310840.html

[16] 一个显卡型号及具体参数整合网站.https://videocardz.net/